- ニューラルネットワークとは

- ニューロンに飛び込む

- ニューラルネットワークはどのように任意の関数をシミュレートしますか

- なぜニューラルネットワークが必要なのですか

- ニューラルネットワークの構築方法

- 完全に接続されたニューラルネットワーク

- グラフィカルツールを使用してニューラルネットワークを設計する

- 出力層の「活性化関数」

- ニューラルネットワークをトレーニングする方法

- 学習アルゴリズムと原理

- ニューラルネットワークをゼロから構築してトレーニングする

- PyTorchを使用してコードを書き直します

- グラフィカルツールを使用してニューラルネットワークをトレーニングする

- ニューラルネットワークのいくつかの重要な問題

- ネットワーク構造

- 過剰適合

- アンダーフィッティング

- 過剰適合と過適合

- 初期化

- 勾配消失と爆発勾配

- 畳み込みニューラルネットワーク(CNN)

- 1D畳み込み

- 1D畳み込み実験

- 1D-pooling

- 1D-CNN実験

- 2D-CNN

- 2D-CNN実験

- リカレントニューラルネットワーク(RNN)

- バニラRNN

- Seq2seq, Autoencoder, Encoder-Decoder

- 高度なRNN

- RNN分類実験

- 自然言語処理

- Embedding: 記号を値に変換する

- テキスト分類1

- テキスト分類2

- TextCNN

- エンティティの認識

- 単語のセグメンテーション、品詞のタグ付け、チャンク

- 実行中のシーケンスタグ付け

- 双方向RNN

- BI-LSTM-CRF

- 注意

- 言語モデル

- n-gramモデル: 単語

- n-gramモデル: 2-gram

- n-gramモデル: 3-gram

- RNN言語モデル

- Transformer言語モデル

- 線形代数

- ベクター

- マトリックス

- 行列の乗算に飛び込む

- テンソル

ニューロンに飛び込む

概要

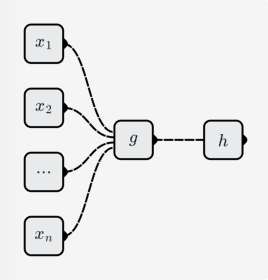

前のセクション(ニューラルネットワークとは)から、ニューラルネットワークはニューロンで構成される関数であり、ニューロンも関数であることがわかりました。

Neuron は、引き続き 2 つのサブ機能に分割できます。

- 要素線形関数:

- 単項非線形関数:

ニューロンによって表される関数は次のとおりです。

線形関数

一次関数の形式は次のとおりです。

その中で、 はすべてパラメーターであり、異なる線形関数には異なるパラメーターがあります。

単項線形関数

、 の場合、関数イメージは直線になります。

バイナリ線形関数

、 の場合、関数イメージは平面です。

要素の線形関数

の場合、関数画像は超平面です。 3D を超えて、視覚化は便利ではありません。しかし、あなたはその特徴がまっすぐであると想像することができます。

非線形関数

非線形関数は線形関数とは異なる関数であることが名前から理解しやすいです。一次関数は直線であり、非線形関数は曲線です。最も一般的なsigmoid関数など:

活性化関数

ニューラルネットワークでは、この単項非線形関数を活性化関数と呼びます。いくつかの一般的なアクティベーション関数については、ナレッジベースのアクティベーション関数を参照してください。ここで、

必要性

非線形活性化関数の後に線形関数を続ける必要があるのはなぜですか?

それの訳は:

- ニューロンがすべて線形関数である場合、ニューロンで構成されるニューラルネットワークも線形関数です。

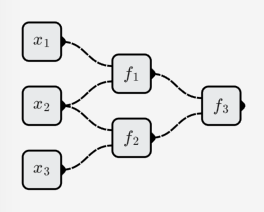

次の例のように:

すると、ニューラルネットワーク全体で表される関数は次のようになります。

これは 3 次線形関数です。

- 構築する必要のある目的関数にはさまざまな関数が含まれていますが、線形関数はその 1 つにすぎません。

ニューラルネットワークが線形関数だけでなく、任意の関数をシミュレートできることを願っています。そこで、非線形活性化関数を追加し、線形関数を「曲げ」ました。

完全なニューロン

完全なニューロンは、線形関数と非線形活性化関数を組み合わせて、より面白くて強力にします。

単項関数

、 の場合、sigmoid活性化関数を使用すると、ニューロンの対応する関数は次のようになります。

関数イメージは次のとおりです。

バイナリ関数

、 の場合、sigmoid活性化関数を使用すると、ニューロンの対応する関数は次のようになります。

関数イメージは次のとおりです。

-要素関数

視覚化の問題のため、ここでは完全に私自身の想像力次第です! 😥

質問

ニューラルネットワークがニューロンの組み合わせから複雑な機能をシミュレートできるのはなぜですか?

単純なニューロンを使用して、もう少し複雑な関数をシミュレートする方法を直感的に想像できます。