- 신경망이란

- 뉴런에 뛰어들다

- 신경망은 어떻게 임의의 기능을 시뮬레이션합니까?

- 신경망이 필요한 이유

- 신경망을 구성하는 방법

- 완전히 연결된 신경망

- 그래픽 도구를 사용하여 신경망 설계

- 출력 레이어의 "활성화 기능"

- 신경망을 훈련시키는 방법

- 학습 알고리즘 및 원리

- 처음부터 신경망 구축 및 훈련

- PyTorch를 사용하여 코드 다시 작성

- 그래픽 도구를 사용하여 신경망 훈련

- 신경망의 몇 가지 중요한 문제

- 네트워크 구조

- 과적합

- 언더피팅

- 과적합 대 과소적합

- 초기화

- 그라디언트 소멸 및 그라디언트 폭발

- 합성곱 신경망(CNN)

- 1D 컨볼루션

- 1D 컨볼루션 실험

- 1D 풀링

- 1D-CNN 실험

- 2D-CNN

- 2D-CNN 실험

- 순환 신경망(RNN)

- 바닐라 RNN

- Seq2seq, Autoencoder, Encoder-Decoder

- 고급 RNN

- RNN 분류 실험

- 자연어 처리

- Embedding: 기호를 값으로 변환

- 텍스트 분류 1

- 텍스트 분류 2

- TextCNN

- 엔티티 인식

- 단어 분할, 품사 태깅 및 청크

- 작동 중인 시퀀스 태깅

- 양방향 RNN

- BI-LSTM-CRF

- 주목

- 언어 모델

- n-gram 모델: 언어 모델

- n-gram 모델: 바이그램 모델

- n-gram 모델: 트라이그램 모델

- RNN 언어 모델

- Transformer 언어 모델

- 선형 대수학

- 벡터

- 매트릭스

- 행렬 곱셈에 대해 자세히 알아보기

- 텐서

뉴런에 뛰어들다

개요

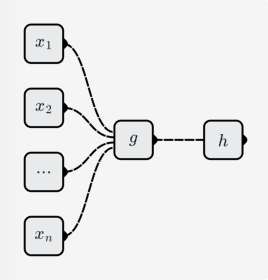

이전 섹션(신경망이란?)에서 신경망은 뉴런으로 구성된 함수이며 뉴런도 함수라는 것을 배웠습니다.

뉴런은 계속해서 2개의 하위 기능으로 나눌 수 있습니다.

- 요소 선형 함수:

- 단항 비선형 함수:

뉴런이 나타내는 기능은 다음과 같습니다.

선형 함수

선형 함수의 형식은 다음과 같습니다.

그 중 는 모두 매개변수이며 선형 함수마다 매개변수가 다릅니다.

단항 선형 함수

, 일 때 함수 이미지는 직선입니다.

이진 선형 함수

, 일 때 함수 이미지는 평면입니다.

요소 선형 함수

일 때 함수 이미지는 초평면입니다. 3D를 넘어서는 시각화는 편리하지 않습니다. 그러나 그 특성이 직선적이라고 상상할 수 있습니다.

비선형 함수

비선형 함수는 선형 함수와 다른 함수라는 이름에서 이해하기 쉽습니다. 선형 함수는 직선이고 비선형 함수는 곡선입니다. 가장 일반적인 sigmoid 함수와 같은:

활성화 기능

신경망에서는 이 단항 비선형 함수를 활성화 함수라고 부릅니다. 몇 가지 일반적인 활성화 기능에 대해서는 지식 기반의 활성화 기능을 참조하십시오. 여기서:

필요성

비선형 활성화 함수 다음에 선형 함수가 와야 하는 이유는 무엇입니까?

이 때문입니다:

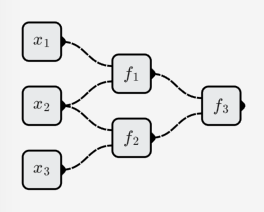

- 뉴런이 모두 선형 함수라면 뉴런으로 구성된 신경망도 선형 함수입니다.

예를 들면 다음과 같습니다.

그러면 전체 신경망이 나타내는 함수는 다음과 같습니다.

이것은 삼항 선형 함수입니다.

- 우리가 구성해야 하는 목적 함수는 다양한 함수를 포함하며 선형 함수는 그 중 하나일 뿐입니다.

우리는 신경망이 선형 함수뿐만 아니라 임의의 함수를 시뮬레이션할 수 있기를 바랍니다. 그래서 우리는 비선형 활성화 함수를 추가하고 선형 함수를 "구부렸습니다".

완전한 뉴런

완전한 뉴런은 선형 함수와 비선형 활성화 함수를 결합하여 더 흥미롭고 강력하게 만듭니다.

단항 함수

, 일 때 sigmoid 활성화 함수를 사용하여 뉴런의 해당 함수는 다음과 같습니다.

기능 이미지는 다음과 같습니다.

이진 함수

, 일 때 sigmoid 활성화 함수를 사용하여 뉴런의 해당 함수는 다음과 같습니다.

기능 이미지는 다음과 같습니다.

-요소 함수

시각화 문제로 인해 여기에서는 전적으로 내 상상에 달려 있습니다! 😥

질문

신경망이 뉴런 조합에서 복잡한 기능을 시뮬레이션할 수 있는 이유는 무엇입니까?

간단한 뉴런을 통해 조금 더 복잡한 기능을 시뮬레이션하는 방법을 직관적으로 상상할 수 있습니다.